Tập huấn mô hình

Sau 20 epoch huấn luyện, tốc độ học của mô hình giảm từ 0.005 xuống 0.000006 (Hình 5A), với sự suy giảm sau mỗi ba epoch. Giá trị hàm mất mát giảm từ 0.1914 xuống 0.0839 (Hình 5B), giảm nhanh trong sáu epoch đầu tiên và sau đó dần hội tụ. Giá trị mAP tổng thể tăng theo số vòng huấn luyện và cuối cùng ổn định ở khoảng 0.9881 (Hình 5C). Sự hội tụ dần và ổn định của giá trị hàm mất mát cùng tốc độ học ở mức thấp cho thấy dự đoán của mô hình ngày càng phù hợp với kết quả thực tế, khẳng định độ tin cậy của quá trình huấn luyện. Sự ổn định dần của mAP ở mức cao chứng minh khả năng nhận diện mạnh mẽ của mô hình được phát triển trong nghiên cứu này.

Fig. 5

Model training process. A mAP. B Loss. C Learning rate

Quá trình huấn luyện mô hình. A mAP. B Hàm mất mát. C Tốc độ học.

Kiểm định mô hình

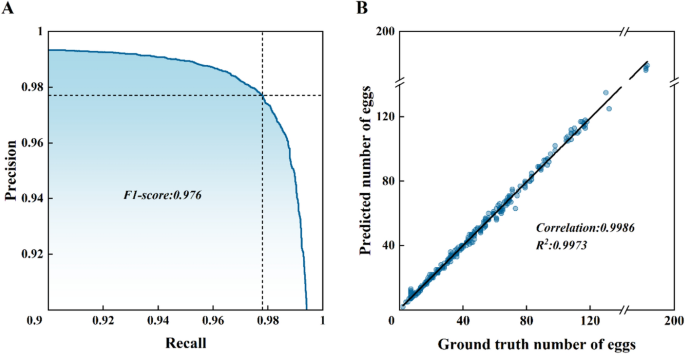

Chia các ảnh thành 16 ô chồng lấn, đưa vào mô hình để nhận dạng, sau đó ghép kết quả đầu ra sau khi sàng lọc dựa trên hình thái trứng muỗi. Chúng tôi tính toán độ chính xác (precision), độ nhạy (recall) và điểm F1, đồng thời vẽ đường cong precision-recall (P-R) để đánh giá khả năng nhận dạng (Hình 6A). Mô hình đạt kết quả tối ưu khi ngưỡng xác suất dự đoán được thiết lập ở mức 0,9116, với độ chính xác là 0,977, độ nhạy là 0,978 và điểm F1 là 0,977. Về khả năng đếm số lượng trứng, trong tổng số 334 ảnh thuộc bộ dữ liệu kiểm định, số lượng trứng thực tế là 15.952 trong khi số lượng do mô hình đếm được là 15.974. Phân tích hồi quy giữa số lượng trứng thực tế và số lượng dự đoán trên từng ảnh cho hệ số xác định R2 là 0,997 (Hình 6B), hệ số tương quan Pearson là 0,994 và sai số căn bậc hai trung bình (RMSE) là 1,742. Trong tổng số 344 ảnh kiểm định, có 140 ảnh cho kết quả nhận dạng khớp hoàn toàn với số lượng thực tế và 321 ảnh có sai số trong phạm vi ba trứng, dẫn đến sai số đếm trung bình là 3,7%.

Hình. 6

Đánh giá khả năng nhận dạng và đếm của mô hình: A. Đường cong Precision-Recall (Độ chính xác - Độ nhạy) B. Đường cong hồi quy

Bàn luận

So với các nghiên cứu tương tự, phương pháp này thể hiện sự cải tiến đáng kể và chứng minh khả năng nhận dạng mạnh mẽ. Trong quá trình nhận dạng, mô hình có thể xác định chính xác trứng muỗi Ae. albopictus ở mật độ từ thấp đến trung bình (Hình 7A), thậm chí có thể nhận diện được cả những quả trứng không nguyên vẹn (Hình 7B). Mô hình cũng có khả năng loại bỏ hiệu quả các tạp chất kích thước lớn (Hình 7A). Tuy nhiên, các hạt sỏi có hình dạng và màu sắc tương tự như trứng muỗi rất khó loại bỏ và dễ bị nhận diện nhầm thành trứng muỗi Ae. albopictus (Hình 7D), gây ảnh hưởng tiêu cực đến độ chính xác của mô hình. Ngoài ra, các cụm trứng mật độ cao dễ dẫn đến hiện tượng âm tính giả, làm giảm khả năng phát hiện (recall) của mô hình (Hình 7C). Hai tình huống này là những thách thức lớn nhất trong cả việc nhận dạng và đếm thủ công lẫn tự động bằng máy móc. Tuy vậy, phương pháp của chúng tôi vẫn duy trì độ chính xác cao tương đương với phương pháp nhận dạng thủ công, đồng thời giảm đáng kể thời gian xử lý. Hơn nữa, phương pháp này còn cho thấy khả năng đếm mạnh mẽ nhờ vào tỷ lệ chính xác và tỷ lệ phát hiện cao.

Hình. 7

Các trường hợp nhận dạng trứng. A Trứng muỗi Aedes albopictus mật độ từ thấp đến trung bình. B Trứng muỗi không hoàn chỉnh. C Trứng muỗi Aedes albopictus mật độ cao. D Các tạp chất tương tự như trứng.

Để phân tích toàn diện khả năng ứng dụng của mô hình trong các tình huống khác nhau, họ đã phân loại 344 hình ảnh thử nghiệm thành ba nhóm dựa trên mức độ khó khăn: Dễ (mật độ trứng từ thấp đến trung bình, ít tạp chất), Trung bình (mật độ trứng trung bình, có một số tạp chất) và Khó (mật độ trứng cao, lượng lớn tạp chất). Hình 8. trình bày kết quả đánh giá, các hình ảnh được phân chia dựa trên mức độ khó khăn khi gắn nhãn thủ công, với tổng cộng 98 trường hợp dễ, 192 trường hợp trung bình và 54 trường hợp khó. Trong các tình huống dễ, mô hình thể hiện hiệu suất tốt nhất, gần tương đương với hiệu suất trên các chủng muỗi trong phòng thí nghiệm. Kết quả này cho thấy mặc dù mô hình được huấn luyện trên các chủng hoang dã, nhưng vẫn cung cấp đầy đủ thông tin về trứng muỗi Aedes albopictus và thể hiện khả năng nhận dạng mạnh mẽ đối với trứng, có thể chuyển đổi để sử dụng cho các chủng trong phòng thí nghiệm.

Các tình huống trung bình là trường hợp phổ biến nhất gặp phải trong thực tế ứng dụng. Độ chính xác của mô hình trong các tình huống trung bình gần nhất với độ chính xác chung của toàn bộ mô hình khi không phân biệt tình huống. Trong các tình huống khó, các chỉ số precision, recall, điểm F1 và ngưỡng phát hiện đều giảm xuống. Nguyên nhân là do trong các tình huống này, mật độ trứng cao làm giảm xác suất dự đoán của trứng. Vì vậy, trong thực tế ứng dụng, việc điều chỉnh thích hợp các ngưỡng phát hiện theo từng tình huống cụ thể có thể cải thiện phần nào độ chính xác phát hiện của mô hình.

Hình. 8

Đánh giá khả năng ứng dụng của mô hình trong các tình huống khác nhau. Đường cong hồi quy: A dễ, B trung bình, C khó. Các giá trị đánh giá mô hình: D dễ, E trung bình, F khó

Để kiểm chứng hiệu quả của mô hình trong việc đếm trứng muỗi Ae. albopictus, họ đã so sánh thời gian đếm bằng kính lúp với phương pháp đếm thủ công. Lựa chọn ngẫu nhiên 3 hình ảnh mức độ dễ, 5 hình ảnh mức độ trung bình và 2 hình ảnh mức độ khó về trứng muỗi Ae. albopictus nhằm phản ánh sát nhất tỷ lệ trong bộ dữ liệu. Kết quả so sánh được trình bày trong Bảng 1. Thời gian đếm thủ công không chỉ liên quan đến số lượng trứng muỗi trong ảnh mà còn phụ thuộc vào độ phức tạp của nền và mật độ trứng, những yếu tố này có thể ảnh hưởng tiêu cực đến thời gian xử lý nhận dạng. Khi bỏ qua tác động của nền và mật độ, thời gian đếm thủ công có tương quan cao với số lượng trứng. Nền phức tạp và mật độ trứng cao làm tăng thời gian đếm. Tuy nhiên, hiệu quả đếm hầu như không bị ảnh hưởng khi áp dụng phương pháp của chúng tôi, với thời gian phát hiện trung bình là 0,48 giây mỗi ô (tile) và 7,94 giây cho toàn bộ hình ảnh khi sử dụng phương pháp chia ô có chồng lấn. Hệ số biến thiên nhỏ hơn 1%, cho thấy mô hình ổn định và nhất quán về hiệu suất. Trong khi vẫn đảm bảo kết quả đếm chất lượng cao, phương pháp của chúng tôi nhanh hơn ít nhất 10 lần so với phương pháp tương tác người–máy tính. Trong trường hợp hình ảnh chứa lượng lớn trứng phân bố dày đặc trên nền phức tạp, mô hình thể hiện sự cải thiện hiệu quả vượt quá 50 lần.

Họ cũng đã thiết kế các thí nghiệm nhằm kiểm chứng khả năng ứng dụng rộng rãi của phương pháp trong các tình huống thực tế. Để đánh giá độ nhạy của phương pháp đối với thông số kỹ thuật của camera, chúng tôi đã khảo sát ảnh hưởng của việc sử dụng các thiết bị thu nhận hình ảnh có thông số kỹ thuật thấp hơn lên kết quả thí nghiệm. Sử dụng OpenCV để giảm độ phân giải của hình ảnh, mô phỏng các hình ảnh với độ phân giải khác nhau từ nhiều thiết bị khác nhau. Ngưỡng lọc hình thái học được điều chỉnh tương ứng theo tỷ lệ độ phân giải. Kết quả được trình bày trong Bảng 2 cho thấy, ngay cả khi độ phân giải của hình ảnh giảm xuống còn một nửa so với ban đầu, chỉ số F1 của mô hình vẫn duy trì ổn định. Điều này chứng tỏ phương pháp của chúng tôi có tính ổn định cao và yêu cầu phần cứng thấp, phù hợp với hầu hết các loại camera, bao gồm cả thiết bị di động. Ngay cả khi độ phân giải chỉ còn một phần tư so với ban đầu, độ chính xác và độ nhạy (recall) của mô hình vẫn vượt trên 0,9. Hơn nữa, khi độ phân giải quá thấp, việc áp dụng học chuyển giao (transfer learning) dựa trên mô hình của chúng tôi có thể cải thiện đáng kể độ chính xác nhận dạng. Các thí nghiệm này khẳng định tính ứng dụng cao của phương pháp và chứng minh tiềm năng áp dụng rộng rãi trong thực tiễn.

Mặc dù Arista-Jalife và cộng sự đã có đóng góp quan trọng khi tăng số lượng mẫu huấn luyện từ 916 lên 18.320 bằng cách xoay ngẫu nhiên và dịch chuyển hình ảnh theo chiều ngang và chiều dọc, nhưng sự đa dạng trong mẫu huấn luyện của họ vẫn có thể chưa đủ phong phú, dẫn đến khả năng tổng quát hóa của mô hình tương đối yếu. Để khắc phục vấn đề này, chúng tôi đã thu thập thêm 1729 ảnh trứng muỗi Aedes albopictus chủng hoang dã trong nhiều tình huống phức tạp khác nhau nhằm tăng tính đa dạng cho tập mẫu. Tuy nhiên, môi trường sống của muỗi Ae. albopictus rất phức tạp; do đó trong nghiên cứu tiếp theo, tập dữ liệu huấn luyện cần được mở rộng hơn nữa để bao gồm nhiều tình huống đa dạng hơn. Hiệu suất nhận dạng của mô hình đề xuất giảm xuống trong các trường hợp mật độ trứng cao cùng với nhiều tạp chất tương tự về mặt hình thái; đây cũng là những tình huống khó khăn nhất đối với phương pháp thủ công truyền thống. Để cải thiện hiệu suất nhận dạng trong những tình huống này, nghiên cứu tiếp theo cần tập trung tăng số lượng mẫu ảnh chứa trứng muỗi mật độ cao trong nhiều bối cảnh phức tạp khác nhau cũng như bổ sung thêm các mẫu âm tính chứa những tạp chất tương tự để nâng cao khả năng nhận dạng của mô hình.

Garcia và cộng sự đã loại bỏ các vùng đen xuất hiện trong quá trình chụp ảnh bằng kính phóng đại trước khi huấn luyện mô hình, cung cấp những hiểu biết quý giá cho quy trình tiền xử lý hình ảnh. Chúng tôi đã cải tiến thao tác này bằng cách sử dụng SAM, tập trung vào vùng quan tâm, giảm đáng kể nhiễu từ nền phức tạp. Tuy nhiên, hạn chế của phương pháp này là các bộ câu lệnh cần thiết cho SAM phải được cung cấp thủ công. Để khắc phục điều này, chúng tôi đã thiết kế một bộ câu lệnh điểm, cho phép xử lý hàng loạt với một lần điều chỉnh tham số thủ công. Các nỗ lực nghiên cứu trong tương lai có thể tập trung vào việc lựa chọn bộ câu lệnh điểm tự động cho các lô ảnh khác nhau.

KẾT LUẬN

Để vượt qua thách thức về nhận dạng chính xác và hiệu quả về trứng muỗi khi giám sát mật độ Ae.albopictussử dụng bẫy đẻ trứng trong môi trường tự nhiên, nghiên cứu này đã xây dựng một bộ dữ liệu hình ảnh trứng muỗi Ae.albopictus từ các chủng hoang dã và tối ưu hóa quy trình tiền xử lý hình ảnh sử dụng SAM. Các nhà khoa học đã huấn luyện một mô hình Faster R-CNN ResNet50 FPN đặc biệt để phát hiện mục tiêu nhỏ dựa trên phân đoạn hình ảnh, sử dụng phương pháp “chồng lấp ô’ để nhận dạng trứng muỗi Ae.albopictus, và loại bỏ tạp chất thông qua lọc hình thái học. Mô hình cuối cùng thể hiện hiệu suất mạnh mẽ trong việc nhận dạng và đếm trứng muỗi Ae.albopictus. Hiệu quả của phương pháp này ít nhất gấp 10 lần so với phương pháp tương tác người-máy, thậm chí còn cao hơn 50 lần trong các tình huống phức tạp, khiến nó trở nên cực kỳ hiệu quả để nhận dạng và đếm trứng trong các chủng hoang dã với nền phức tạp.

Bài viết trên được dịch tóm lược hầu hết các ý chính của công nghệ AI và máy học để phân tích, một lĩnh vực còn nhiều mới mẻ và sẽ không tránh khỏi các điểm dịch từ chuyên ngành chưa sát nghĩa, tuy nhiên, các khía cạnh này còn rất mới mẻ ở Việt Nam, nên hy vọng tài liệu này sẽ là nguồn tài liệu tham khảo có giá trị cho các nhà khoa học đang có ý định đưa công nghệ số vào nghiên cứu bệnh vector truyền, vui lòng truy cập https://figshare.com/s/06269306f9aa95ce8d63.

Tài liệu tham khảo

- 1.Simmons CP, Farrar JJ, van Vinh CN, Wills B. Dengue. N Engl J Med. 2012;366:1423–32.

- 2.Guzman MG, Gubler DJ, Izquierdo A, Martinez E, Halstead SB. Dengue infection. Nat Rev Dis Primers. 2016;2:1–25.

- 3.Jing Q, Wang M. Dengue epidemiology. Glob Health J. 2019;3:37–45.

- 4.Lee H, Halverson S, Ezinwa N. Mosquito-borne diseases. Prim Care. 2018;45:393–407.

- 5.Shepard DS, Undurraga EA, Halasa YA, Stanaway JD. The global economic burden of dengue: a systematic analysis. Lancet Infect Dis. 2016;16:935–41.

- 6.Gubler DJ. Epidemic dengue/dengue hemorrhagic fever as a public health, social and economic problem in the 21st century. Trends Microbiol. 2002;10:100–3.

- 7.Franklinos LH, Jones KE, Redding DW, Abubakar I. The effect of global change on mosquito-borne disease. Lancet Infect Dis. 2019;19:e302–12.

- 8.Tatem AJ, Hay SI, Rogers DJ. Global traffic and disease vector dispersal. Proc Natl Acad Sci. 2006;103:6242-7.

- 9.Liu H, Huang X, Guo X, Cheng P, Wang H, Liu L, et al. Climate change and Aedes albopictus risks in China: current impact and future projection. Infect Dis Poverty. 2023;12:26.

- 10.Van Kleef E, Bambrick H, Hales S. The geographic distribution of dengue fever and the potential influence of global climate change. TropIKA net. 2010;2010:1–22.

- 11.Gubler DJ. Dengue, urbanization and globalization: the unholy trinity of the 21st century. Trop Med Health. 2011;39:S3–11.

- 12.Lin P-S, Liu W-L, Chen C-D, Wen T-H, Chen C-H, Chen L-W, et al. Micro-scale urbanization-based risk factors for dengue epidemics. Int J Biometeorol. 2024;68:133–41.

- 13.Bhatt S, Gething PW, Brady OJ, Messina JP, Farlow AW, Moyes CL, et al. The global distribution and burden of dengue. Nature. 2013;496:504–7.

- 14.Messina JP, Brady OJ, Golding N, Kraemer MU, Wint GW, Ray SE, et al. The current and future global distribution and population at risk of dengue. Nat Microbiol. 2019;4:1508–15.

- 15.Waickman AT, Newell K, Endy TP, Thomas SJ. Biologics for dengue prevention: up-to-date. Expert Opin Biol Ther. 2023;23:73–87.

- 16.World Health Organization. A global brief on vector-borne diseases. World Health Organization; 2014.

- 17.Wilson AL, Courtenay O, Kelly-Hope LA, Scott TW, Takken W, Torr SJ, et al. The importance of vector control for the control and elimination of vector-borne diseases. PLoS Negl Trop Dis. 2020;14:e0007831.

- 18.Williams CR, Johnson P, Ball T, Ritchie S. Productivity and population density estimates of the dengue vector mosquito Aedes aegypti (Stegomyia aegypti) in Australia. Med Vet Entomol. 2013;27:313–22.

- 19.Fillinger U, Sombroek H, Majambere S, van Loon E, Takken W, Lindsay SW. Identifying the most productive breeding sites for malaria mosquitoes in The Gambia. Malar J. 2009;8:1–14.

- 20.Kay B. Dengue vector surveillance and control. Curr Opin Infect Dis. 1999;12:425–32.

- 21.Schaffner F, Bellini R, Petrić D, Scholte E-J, Zeller H, Marrama RL. Development of guidelines for the surveillance of invasive mosquitoes in Europe. Parasites Vectors. 2013;6:1–10.

- 22.Norzahira R, Hidayatulfathi O, Wong H, Cheryl A, Firdaus R, Chew H, et al. Ovitrap surveillance of the dengue vectors, Aedes (Stegomyia) aegypti (L.) and Aedes (Stegomyia) albopictus Skuse in selected areas in Bentong, Pahang, Malaysia. Trop Biomed. 2011;28:48–54.

- 23.Sasmita HI, Neoh K-B, Yusmalinar S, Anggraeni T, Chang N-T, Bong L-J, et al. Ovitrap surveillance of dengue vector mosquitoes in Bandung city, West Java province, Indonesia. PLoS Negl Trop Dis. 2021;15:e0009896.

- 24.Manica M, Rosà R, della Torre A, Caputo B, editors. Estimating mosquito/host contact from ovitrap data: a case study for Aedes albopictus in Rome. XXIX Congresso SoIPa (Società Italiana di Parassitologia), BAri, Italy, 21–24 giugno 2016; 2016: IT.

- 25.Day JF. Mosquito oviposition behavior and vector control. Insects. 2016;7:65.

- 26.Zhou Y, Zhao T, Leng P. The Application of Aedes Egg Trap in Aedes Monitoring. Chin J Vector Biol Control. 2008;19:487–9.

- 27.Anicic N, Steigmiller K, Renaux C, Ravasi D, Tanadini M, Flacio E. Optical recognition of the eggs of four Aedine mosquito species (Aedes albopictus, Aedes geniculatus, Aedes japonicus, and Aedes koreicus). PLoS ONE. 2023;18:e0293568.

- 28.de Morais LMO, Jussiani EI, Zequi JAC, Dos Reis PJ, Andrello AC. Morphological study of Aedes aegypti and Aedes albopictus (Diptera: Culicidae) eggs by X-ray computed microtomography. Micron. 2019;126:102734.

- 29.da Silva MGNM, Rodrigues MAB, De Araujo R, editors. Aedes aegypti egg counting system. 2011 Annual International Conference of the IEEE Engineering in Medicine and Biology Society; 2011: IEEE.

- 30.Mains JW, Mercer DR, Dobson SL. Digital image analysis to estimate numbers of Aedes eggs oviposited in containers. J Am Mosq Control Assoc. 2008;24:496.

- 31.Bandong S, Joelianto E, editors. Counting of Aedes Aegypti Eggs using Image Processing with Grid Search Parameter Optimization. 2019 International Conference on Sustainable Engineering and Creative Computing (ICSECC); 2019: IEEE.

- 32.Gusmão G, Machado SC, Rodrigues MA, editors. A new algorithm for segmenting and counting Aedes aegypti eggs in ovitraps. 2009 Annual International Conference of the IEEE Engineering in Medicine and Biology Society; 2009: IEEE.

- 33.Mello CA, Dos Santos WP, Rodrigues MA, Candeias ALB, Gusmao CM, editors. Image segmentation of ovitraps for automatic counting of Aedes aegypti eggs. 2008 30th Annual International Conference of the IEEE Engineering in Medicine and Biology Society; 2008: IEEE.

- 34.Ibraheem NA, Hasan MM, Khan RZ, Mishra PK. Understanding color models: a review. ARPN J Sci Technol. 2012;2:265–75.

- 35.Gaburro J, Duchemin J-B, Paradkar PN, Nahavandi S, Bhatti A. Assessment of ICount software, a precise and fast egg counting tool for the mosquito vector Aedes aegypti. Parasites Vectors. 2016;9:1–9.

- 36.Wan Yussof WNJH, Man M, Hitam MS, Hamid AAKA, Awalludin EA, Bakar WAWA, editors. Wavelet-based Auto-Counting Tool of Aedes Eggs. Proceedings of the 2018 international conference on sensors, signal and image processing; 2018.

- 37.Joshi A, Miller C. Review of machine learning techniques for mosquito control in urban environments. Ecol Inform. 2021;61:101241.

- 38.Montgomery BL, Shivas MA, Hall-Mendelin S, Edwards J, Hamilton NA, Jansen CC, et al. Rapid Surveillance for Vector Presence (RSVP): development of a novel system for detecting Aedes aegypti and Aedes albopictus. PLoS Negl Trop Dis. 2017;11:e0005505.

- 39.Mollahosseini A, Rossignol M, Pennetier C, Cohuet A, Anjos AD, Chandre F, et al. A user-friendly software to easily count Anopheles egg batches. Parasites Vectors. 2012;5:1–7.

- 40.Krieshok G TGC. Using computer vision to identify and count mosquito eggs 2020. Available from: https://abtassociates.github.io/mecvision/.

- 41.Zhao Z-Q, Zheng P, Xu S-T, Wu X. Object detection with deep learning: a review. IEEE Trans Neural Netw Learn Syst. 2019;30:3212–32.

- 42.Krizhevsky A, Sutskever I, Hinton GE. Imagenet classification with deep convolutional neural networks. Adv Neural Inf Process Syst. 2012;25.

- 43.Liu X, Faes L, Kale AU, Wagner SK, Fu DJ, Bruynseels A, et al. A comparison of deep learning performance against health-care professionals in detecting diseases from medical imaging: a systematic review and meta-analysis. Lancet Digit Health. 2019;1:e271–97.

- 44.Weichenthal S, Hatzopoulou M, Brauer M. A picture tells a thousand… exposures: opportunities and challenges of deep learning image analyses in exposure science and environmental epidemiology. Environ Int. 2019;122:3–10.

- 45.Pavitra H, Raghavendra C. An overview on detection, counting and categorization of silkworm eggs using image analysis approach. Glob Transit Proc. 2022;3:285–8.

- 46.Khalid S, Oqaibi HM, Aqib M, Hafeez Y. Small pests detection in field crops using deep learning object detection. Sustainability. 2023;15:6815.

- 47.Fuad MAM, Ab Ghani MR, Ghazali R, Izzuddin TA, Sulaima MF, Jano Z, et al. Detection of Aedes aegypti larvae using single shot multibox detector with transfer learning. Bull Electr Eng Inform. 2019;8:514–8.

- 48.Hubalde AM, Padilla DA, Santos DAC, editors. A YOLO-Based Approach for Aedes aegypti Larvae Classification and Detection. 2021 6th International Conference on Image, Vision and Computing (ICIVC); 2021: IEEE.

- 49.Siddiqua R, Rahman S, Uddin J. A Deep learning-based dengue mosquito detection method using faster R-CNN and image processing techniques. Ann Emerg Technol Comput. 2021;5:11–23.

- 50.Javed N, López-Denman AJ, Paradkar PN, Bhatti A. EggCountAI: a convolutional neural network-based software for counting of Aedes aegypti mosquito eggs. Parasites Vectors. 2023;16:341.

- 51.de Santana CJ, Firmo ACA, de Oliveira RFAP, Lins PJB, de Lima GA, de Lima RA. A solution for counting Aedes aegypti and Aedes albopictus eggs in paddles from ovitraps using deep learning. IEEE Lat Am Trans. 2019;17:1987–94.

- 52.Garcia PSC, Martins R, Coelho GLLM, Cámara-Chávez G, editors. Acquisition of digital images and identification of Aedes aegypti mosquito eggs using classification and deep learning. 2019 32nd SIBGRAPI Conference on Graphics, Patterns and Images (SIBGRAPI); 2019: IEEE.

- 53.Kirillov A, Mintun E, Ravi N, Mao H, Rolland C, Gustafson L, et al., editors. Segment Anything. Proceedings of the IEEE/CVF International Conference on Computer Vision; 2023.

- 54.Committee CNSA. Surveillance methods for vector density—Mosquito. 2020.

- 55.Tzutalin. LabelImg: Git code; 2015. Available from: https://github.com/tzutalin/labelImg.

- 56.Li Y, An Q, Sun Z, Gao X, Wang H. Distribution areas and monthly dynamic distribution changes of three Aedes species in China: Aedes aegypti, Aedes albopictus and Aedes vexans. Parasites Vectors. 2023;16:297.

- 57.Lin T-Y, Maire M, Belongie S, Hays J, Perona P, Ramanan D, et al., editors. Microsoft COCO: Common Objects in Context. Computer Vision–ECCV 2014: 13th European Conference, Zurich, Switzerland, September 6–12, 2014, Proceedings, Part V 13; 2014: Springer.

- 58.Tong K, Wu Y, Zhou F. Recent advances in small object detection based on deep learning: a review. Image Vis Comput. 2020;97:103910.

- 59.Ren S, He K, Girshick R, Sun J. Faster R-CNN: towards real-time object detection with region proposal networks. IEEE Trans Pattern Anal Mach Intell. 2016;39:1137–49.

- 60.Lin T-Y, Dollár P, Girshick R, He K, Hariharan B, Belongie S, editors. Feature Pyramid Networks for Object Detection. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition; 2017.

- 61.He K, Zhang X, Ren S, Sun J, editors. Deep Residual Learning for Image Recognition. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition; 2016.

- 62.Win M, Swe T, Sett K, Mya M, Latt A, Soe K, et al. Structural differentiation of Aedes aegypti and Aedes albopictus eggs using Scanning Electron Microscope. J Biol Eng Res Rev. 2018;5:09–12.

- 63.Padilla R, Netto SL, Da Silva EA, editors. A survey on performance metrics for object-detection algorithms. 2020 International Conference on Systems, Signals and Image Processing (IWSSIP); 2020: IEEE.

- 64.Arista-Jalife A, Nakano M, Garcia-Nonoal Z, Robles-Camarillo D, Perez-Meana H, Arista-Viveros HA. Aedes mosquito detection in its larval stage using deep neural networks. Knowl Based Syst. 2020;189:104841.

CN. Nguyễn Thái Hoàng & TS.BS. Huỳnh Hồng Quang

Viện Sốt rét-KST-CT Quy Nhơn